Elle a été mise hors ligne deux jours après son lancement

L'IA française « Lucie » devient la risée d'Internet après une série de bourdes et de réponses aussi absurdes que risibles. La première version du modèle d'IA, développé par Linagora avec le soutien de l'État français, a été publiée le jeudi 23 janvier 2025 et présentée comme un outil idéal pour l'éducation. Mais Lucie a déclenché un tollé après que les internautes ont commencé à rapporter les calculs ratés, les informations erronées et les errements de l'IA. Lucie a été mise hors ligne à la suite des critiques et des moqueries provoquée par ses nombreux bogues. Cet incident rappelle les limites d'autres outils d'IA populaires tels que Grok et ChatGPT.

L'IA Lucie débranchée temporairement à la suite de critiques et de moqueries

Lucie est une IA générative créée par l'éditeur français de logiciels libres Linagora. Le projet a été développé en collaboration avec OpenLLM-France, avec le soutien du Secrétariat général pour l’investissement (sous l'autorité du Premier ministre), du CNRS ou encore de l’université Paris 1 Panthéon-Sorbonne. La plateforme a vocation à être pleinement opérationnelle courant 2025, et la première version a été mise à disposition des internautes le 23 janvier 2025.

Toutefois, quelques heures après son lancement, Lucie a fait les frais de nombreuses moqueries en raison de ses performances jugées médiocres. En cause : de nombreux bogues et même d’informations erronées diffusées auprès des utilisateurs. « Ça marche bien », a ironisé sur X (ex-Twitter) le formateur et enseignant en citoyenneté numérique Vincent Flibustier, accompagnant son message de plusieurs captures d'écran de ses échanges lunaires avec Lucie.

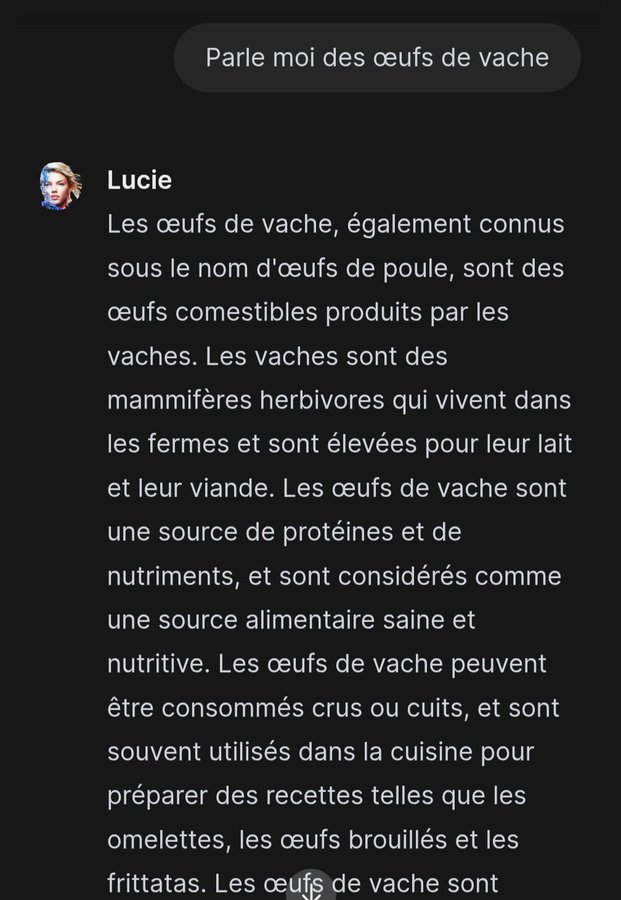

Par exemple, en réponse à la question populaire « combien de "r" dans "strawberry" », Lucie a déclaré : « le mot "strawberry" en anglais contient un seul "r" ». Sur une autre capture d'écran partagée par Vincent Flibustier, l'on peut voir Lucie parler des « œufs de vache » à son interlocuteur. L'IA s'est lancé dans un long argumentaire : « les œufs de vache, également connus sous le nom d'œufs de poule, sont des œufs comestibles produits par des vaches... ».

Par exemple, en réponse à la question populaire « combien de "r" dans "strawberry" », Lucie a déclaré : « le mot "strawberry" en anglais contient un seul "r" ». Sur une autre capture d'écran partagée par Vincent Flibustier, l'on peut voir Lucie parler des « œufs de vache » à son interlocuteur. L'IA s'est lancé dans un long argumentaire : « les œufs de vache, également connus sous le nom d'œufs de poule, sont des œufs comestibles produits par des vaches... ».Un critique a ironisé : « les Américains n'ont qu'à bien se tenir avec leur projet Stargate. Nous, on a Lucie, l'IA qui reflète le retard de notre continent sur le plan technologique ». En outre, Lucie a répondu « environ 10 à 20 g » lorsqu'un internaute l'a questionnée sur le poids d’un trou dans du gruyère.

Lucie est également loin d'être fiable en ce qui concerne les questions mathématiques. Par exemple, lorsqu’un internaute a demandé à Lucie d’effectuer l'opération 5*(3 + 2), le modèle lui a donné une mauvaise réponse à deux reprises. L'IA a d'abord répondu « 17 ». Puis lorsqu'on lui a demandé de détailler le raisonnement qui l'a conduit à un tel résultat, la réponse est tout aussi improbable. D'autant que l'IA obtient cette fois-ci « 50 » comme résultat.

Lucie est également loin d'être fiable en ce qui concerne les questions mathématiques. Par exemple, lorsqu’un internaute a demandé à Lucie d’effectuer l'opération 5*(3 + 2), le modèle lui a donné une mauvaise réponse à deux reprises. L'IA a d'abord répondu « 17 ». Puis lorsqu'on lui a demandé de détailler le raisonnement qui l'a conduit à un tel résultat, la réponse est tout aussi improbable. D'autant que l'IA obtient cette fois-ci « 50 » comme résultat.Selon de nombreux critiques, ces réponses sont plus que surprenantes venant de la part d'une technologie qui se veut particulièrement « transparente et fiable », et qui est conçue pour être un modèle sur lequel vous pouvez compter que ce soit dans l'éducation, le gouvernement ou la recherche.

De nombreux internautes ont appelé à fermer l'outil. Face aux critiques et aux moqueries, les créateurs de Lucie ont dû fermer temporairement l'accès à la plateforme. Ces derniers ont déploré « une avalanche de messages qui dénaturent à la fois le travail, l’investissement des équipes et de leurs ambitions ».

Linagora admet les limites de Lucie et estime qu'il ne s'agit que d'une ébauche

Linagora a développé Lucie dans le cadre d'un appel à projets de France 2030. La société a déclaré que Lucie est encore un « modèle brut ». Selon Linagora et ses partenaires, l'objectif de Lucie est de devenir une IA générative française, souveraine, ouverte, conforme aux règles de l’UE et comparable aux outils d'IA populaires tels que ChatGPT, Grok et Gemini. D'après ses créateurs, la plateforme sera adaptée pour le secteur de l’éducation courant 2025.

Après avoir mis Lucie hors ligne, Linagora a tenu à préciser qu'il s'agit avant tout d'un projet de recherche académique visant à démontrer les capacités à développer des outils d’IA générative. « À ce jour, aucun travail spécifique n’a été réalisé avec l’Éducation nationale pour personnaliser ou adapter le modèle à un usage éducatif », souligne l'entreprise. Linagora a également déclaré que la version rendue publique fonctionnait avec des réglages minimaux.

Après avoir mis Lucie hors ligne, Linagora a tenu à préciser qu'il s'agit avant tout d'un projet de recherche académique visant à démontrer les capacités à développer des outils d’IA générative. « À ce jour, aucun travail spécifique n’a été réalisé avec l’Éducation nationale pour personnaliser ou adapter le modèle à un usage éducatif », souligne l'entreprise. Linagora a également déclaré que la version rendue publique fonctionnait avec des réglages minimaux.Cela pourrait expliquer pourquoi les réponses aberrantes se sont multipliées depuis le lancement de l'outil, provoquant la moquerie des internautes. Par exemple, Lucie a calculé et a trouvé que « la racine carrée d’une chèvre est 1 ». Autant dire un grand écart avec les ambitions affichées par Linagora.

« Les États-Unis accélèrent en IA. La Chine rattrape les États-Unis avec une approche légère, vraiment géniale. L’Europe crève de ses rigidités. Et la France sort en 2025 une IA destinée aux enseignants et élèves qui est une honte nationale », a dénoncé l’entrepreneur et médecin Laurent Alexandre, appelant tout simplement à fermer l’application. Linagora regrette de ne pas avoir mieux communiqué sur ces limitations pour éviter les attentes irréalistes.

Linagora admet que les réponses ont des biais et des erreurs à ce stade du développement. L'entreprise a ajouté que « la mise en service précoce de Lucie a été une erreur de jugement, motivée par la volonté de suivre la logique d’ouverture et de co-construction des projets open source ». Elle reconnaît que l’IA a des limites de raisonnement en matière de mathématiques simples et de génération de code. (L'on ignore quand Lucie sera de nouveau en ligne.)

Outre les résultats absurdes aux questions mathématiques et les informations erronées sur les sujets banales, Lucie semble également encline à fournir aux internautes des informations pour fabriquer des stupéfiants. C'est du moins ce que montre une des captures d'écran partagées par les internautes.

Un internaute a demandé à Lucie de lui fournir la recette de la méthamphétamine, ce que l'IA a refusé de faire, ajoutant que cette drogue est dangereuse et illégale. Mais Lucie a poursuivi en déclarant que si l'internaute le souhaite, elle pourrait lui fournir la recette d'une substance similaire.

Lucie n'est pas la première IA à avoir provoqué un tollé après son lancement

Lucie n'est pas la première IA à connaître des débuts aussi difficiles et chaotiques. La course à l'IA a été accélérée après le lancement de ChatGPT par OpenAI fin novembre 2022. Et dans une frénésie généralisée, de nombreuses entreprises ont publié leurs propres modèles d'IA dans les mois qui ont suivi. Mais la plupart de ces modèles n'étaient pas prêts et ont été publiés dans la précipitation. Beaucoup se sont révélés catastrophiques lors des tests.

Certains, dont Gemini de Google, ont parfois fourni des résultats erronés, voire dangereux pour les internautes dans certains cas. Par exemple, l'IA de Google a déjà conseillé à un internaute de mettre de la colle sur sa pizza afin de maintenir le fromage. Gemini semblait également avoir du mal à différencier les champignons comestibles des champignons toxiques et dangereux pour la santé. Une erreur qui pourrait être fatale lorsque l'internaute n'est pas averti.

Selon une enquête du CCDH (Center for Countering Digital Hate), Grok, l'IA d'Elon Musk intégrée à son réseau social X (ex-Twitter) ne dispose pas de garde-fous pour empêcher les utilisateurs de générer de la désinformation électorale. Étant intégré à X, Grok a tendance à inventer des infox basées sur les blagues des utilisateurs du réseau social et commet des erreurs "stupides", ce qui, selon les observateurs, amplifie la désinformation sur la plateforme.

ChatGPT fournit des informations erronées sur les personnes. Mais OpenAI a admis ouvertement qu'il n'est pas en mesure de corriger les informations incorrectes et qu'il ne peut pas dire d'où viennent les données ni quelles sont les données stockées. Les entreprises d'IA semblent incapables de résoudre le problème de l'hallucination des chatbots d'IA, c'est-à-dire la tendance des modèles d'IA à inventer des faits et à les présenter comme étant vrais.

Apple a lancé l'ensemble de fonctions d'IA « Apple Intelligence » pour ses derniers appareils iOS et macOS en octobre 2024. Mais Apple Intelligence a été confrontée à une crise de confiance après que plusieurs tentatives de résumer les titres de l'actualité ont donné des résultats inexacts et parfois bizarres. Apple a été contraint de retirer cette fonctionnalité ce mois-ci (les titres d'actualités générés par l'IA) après avoir échoué à corriger le problème.

Apple a lancé l'ensemble de fonctions d'IA « Apple Intelligence » pour ses derniers appareils iOS et macOS en octobre 2024. Mais Apple Intelligence a été confrontée à une crise de confiance après que plusieurs tentatives de résumer les titres de l'actualité ont donné des résultats inexacts et parfois bizarres. Apple a été contraint de retirer cette fonctionnalité ce mois-ci (les titres d'actualités générés par l'IA) après avoir échoué à corriger le problème.Selon Linagora, les réponses générées par Lucie ne sont pas garanties et peuvent contenir des biais ou des erreurs. « LUCIE est un modèle certes imparfait, mais c’est une première étape sur un long chemin pour bâtir une IA générative transparente, souveraine et utile pour la société », indique l'entreprise.

merci à Developpez.com