Comme Le Chat de Mistral, le moteur de recherche IA Perplexity va gagner en réactivité grâce aux technologies de puces de Cerebras.

Il y a quelques jours, le français Mistral AI annonçait pouvoir apporter à son agent IA Le Chat une grande réactivité dans le temps de réponse en atteignant les 1100 token/s là où la concurrence répond avec des débits de quelques dizaines de tokens/s.

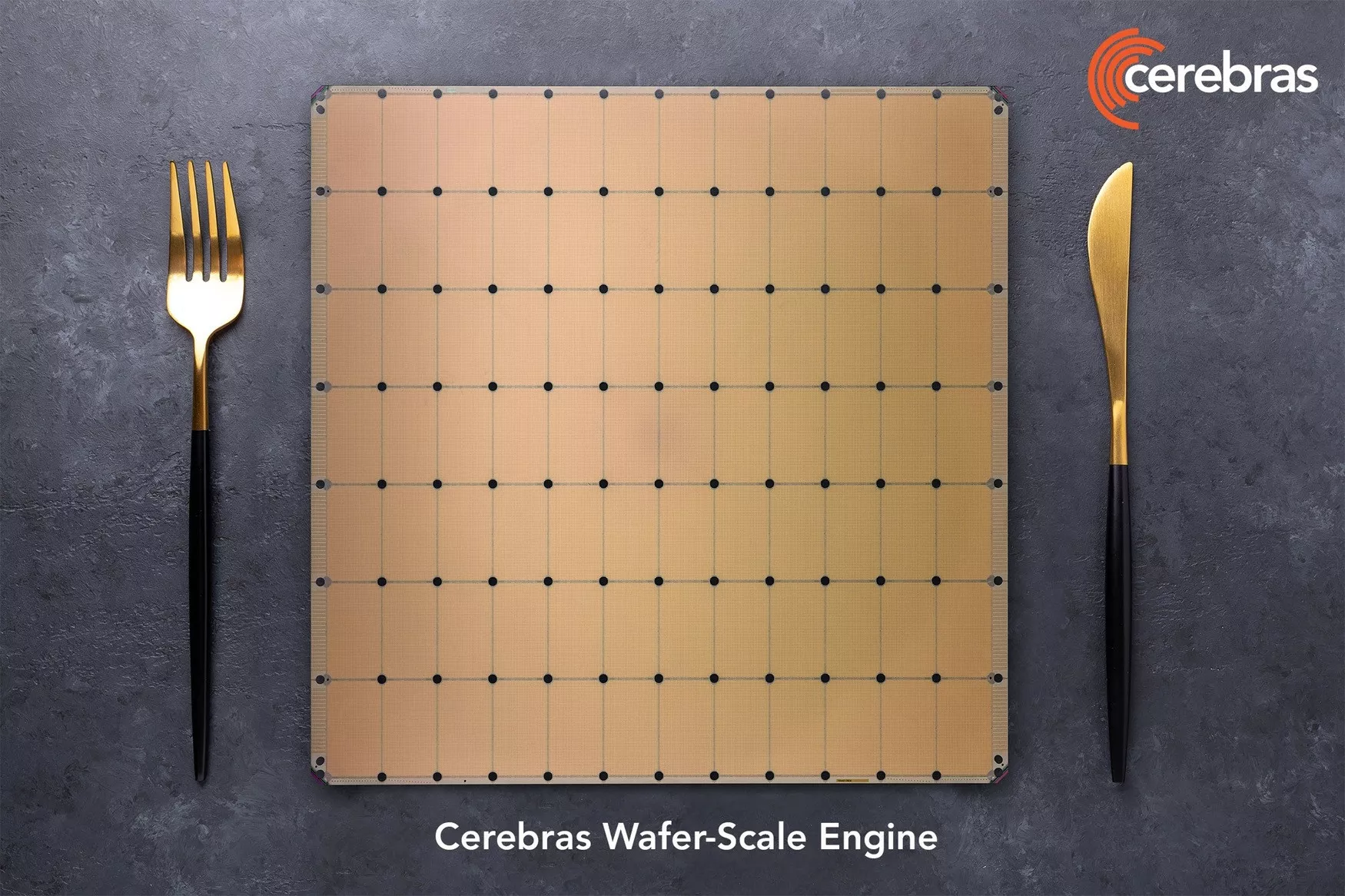

Il y a quelques jours, le français Mistral AI annonçait pouvoir apporter à son agent IA Le Chat une grande réactivité dans le temps de réponse en atteignant les 1100 token/s là où la concurrence répond avec des débits de quelques dizaines de tokens/s.Cela est rendu possible par la technologie de puces sur wafer de la firme américaine Cerebras. Cette dernière développe des systèmes comprenant des centaines de milliers de coeurs réunis sur un même wafer, travaillant et communiquant ensemble grâce à une grosse quantité de mémoire partagée.

Perplexity super réactif avec 1200 token/s

Ce système, baptisé Wafer System Engine (ou WSE), est une puissante alternative aux énormes quantités de GPU utilisées dans les datacenters IA, et il sert déjà à bâtir des supercalculateurs IA dont la puissance de calcul sera distribuée.

Alors que que les modèles d'intelligence artificielles rivalisent dans les performances, l'un des arguments différenciants pourrait devenir leur rapidité de réponse.

Cela peut grandement faciliter le mode de communication conversationnel et donner une nouvelle dimension aux échanges avec l'IA. Et Mistral n'est pas le seul à vouloir mettre en avant cet aspect.

Cela peut grandement faciliter le mode de communication conversationnel et donner une nouvelle dimension aux échanges avec l'IA. Et Mistral n'est pas le seul à vouloir mettre en avant cet aspect.Le moteur de recherche IA Perplexity vient d'annoncer un partenariat similaire avec Cerebras pour son API Sonar. Sa particularité est de pouvoir fournir des informations pertinentes et récentes en se connectant en temps réel à Internet...mais aussi très rapidement puisque son débit de sortie est annoncé à 1200 tokens/s, soit donc encore mieux que Le Chat !

GPU vs puces IA spécialisées, à chacun ses avantages

Cette avancée veut aussi mettre en avant l'intérêt des puces spécialisées par rapport aux GPU qui constituent actuellement l'épine dorsale des modèles d'IA et la raison des investissements de dizaines de milliards de dollars en cours pour en bâtir les infrastructures.

L'un des atouts reste la capacité de changement d'échelle en réunissant toujours plus de composants entre eux et c'est ce que tente de démontrer Cerebras avec les supercalculateurs Condor Galaxy mais la firme n'a pas encore un soutien massif de l'industrie et ne peut aligner autant de ressources que celles proposées avec les GPU de Nvidia ou AMD.

L'un des atouts reste la capacité de changement d'échelle en réunissant toujours plus de composants entre eux et c'est ce que tente de démontrer Cerebras avec les supercalculateurs Condor Galaxy mais la firme n'a pas encore un soutien massif de l'industrie et ne peut aligner autant de ressources que celles proposées avec les GPU de Nvidia ou AMD.Les partenariats avec Mistral AI et Perplexity permettent déjà à Cerebras de démontrer tout le potentiel de ses puces IA spécialisées en mettant en avant une réactivité 10 fois supérieures par rapport aux modèles d'IA utilisant des GPU.

merci à GNT