Sous licence Apache 2.0, Mistral AI tente aussi de bousculer l'ordre établi avec son nouveau modèle IA dénommé Mistral Small 3. Plus petit, plus rapide et moins cher.

« Mistral Small 3 complète les grands modèles de raisonnement open source tels que les sorties récentes de DeepSeek, et peut servir de modèle de base solide pour faire émerger des capacités de raisonnement. »

« Mistral Small 3 complète les grands modèles de raisonnement open source tels que les sorties récentes de DeepSeek, et peut servir de modèle de base solide pour faire émerger des capacités de raisonnement. »En dévoilant son nouveau modèle Mistral Small 3, la start-up française d'intelligence artificielle générative Mistral AI refait parler d'elle, mais évite une confrontation directe avec le modèle de raisonnement chinois DeepSeek-R1 de DeepSeek qui bouscule les géants américains en raison d'un coût très inférieur.

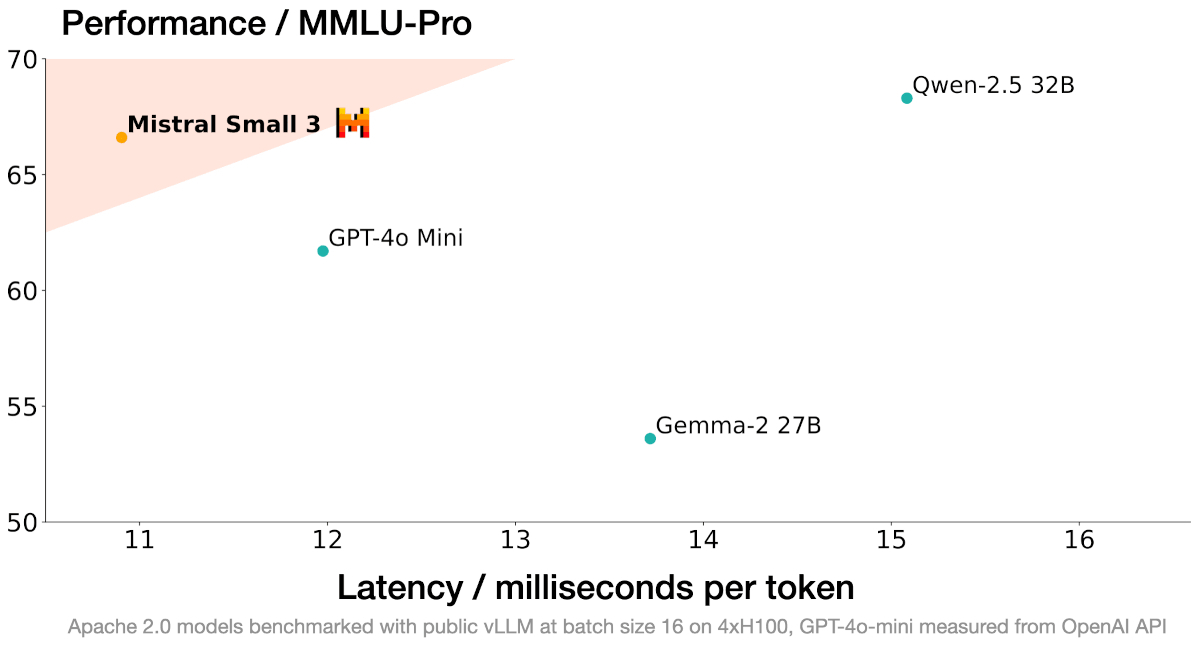

Reste qu'avec ses 24 milliards de paramètres, Mistral Small 3 est présenté compétitif par rapport à des modèles de type LLM (Large Language Model) plus grands comme Llama 3.3 70B de Meta (trois fois plus important) et Qwen-2.5 32B d'Alibaba.

Licence Apache 2.0 et déploiement en local

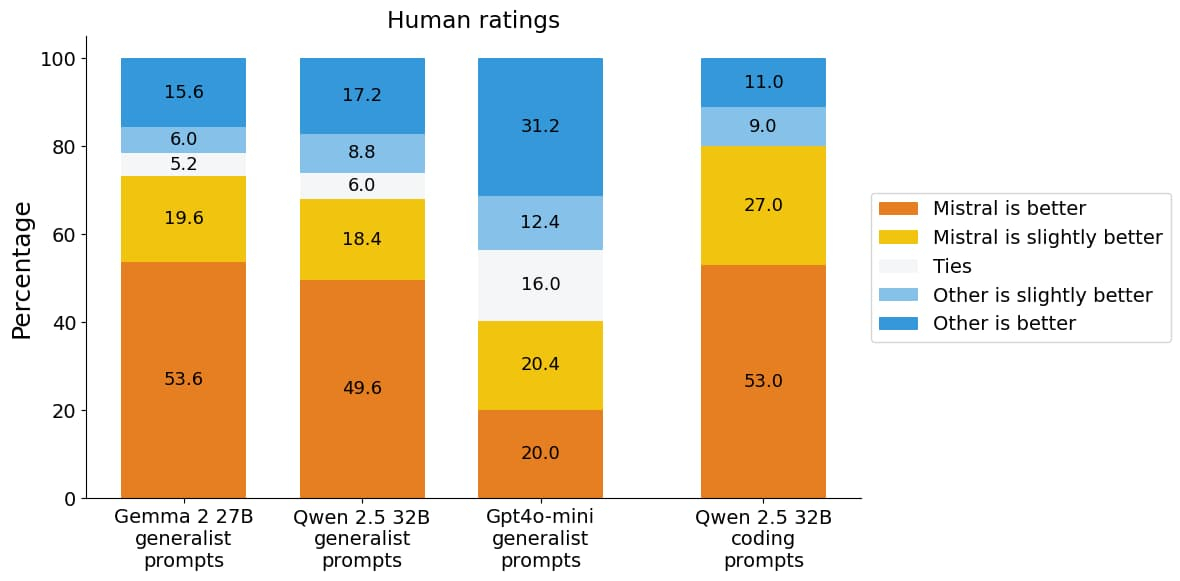

Licence Apache 2.0 et déploiement en localAvec une mise à disposition sous licence Apache 2.0, Mistral AI vante également un excellent remplaçant open source à GPT4-o mini d'OpenAI. « Nous renouvelons notre engagement à utiliser la licence Apache 2.0 pour nos modèles à usage général. »

Rapide et avec une latence faible, Mistral Small 3 se démarque dans les tâches d'IA générative nécessitant des performances robustes en matière de langage et de suivi des instructions. Une précision de plus de 81 % sur MMLU (Massive Multitask Language Understanding) et une latence de 150 tokens par seconde.

Rapide et avec une latence faible, Mistral Small 3 se démarque dans les tâches d'IA générative nécessitant des performances robustes en matière de langage et de suivi des instructions. Une précision de plus de 81 % sur MMLU (Massive Multitask Language Understanding) et une latence de 150 tokens par seconde.Il est souligné que l'entraînement du modèle repose uniquement sur des données réelles et n'implique pas d'optimisation via apprentissage par renforcement.

Mistral AI explique que son nouveau modèle a été conçu pour saturer les performances à une taille adaptée au déploiement en local. Mistral Small 3 peut notamment être exécuté sur un PC équipé d'une carte graphique RTX 4090 de Nvidia ou un MacBook avec 32 Go de RAM.

Aussi sur diverses plateformes

Mistral Small 3 est proposé sur plusieurs plateformes : La Plateforme de Mistrail AI, Hugging Face, Ollama, Kaggle, Together AI, Fireworks AI. D'autres suivront bientôt : Nvidia NIM, Amazon SageMaker, Groq, Databricks et Snowflake.

merci à GNT